< Bu mesaj bu kişi tarafından değiştirildi DH Anonim -- 22 Nisan 2022; 9:32:56 > |

|

_____________________________

İmzanız kural dışıdır! || Uymanız gereken imza kurallarını okumak için tıklayınız.

|

Yeni Kayıt

Yeni Kayıt

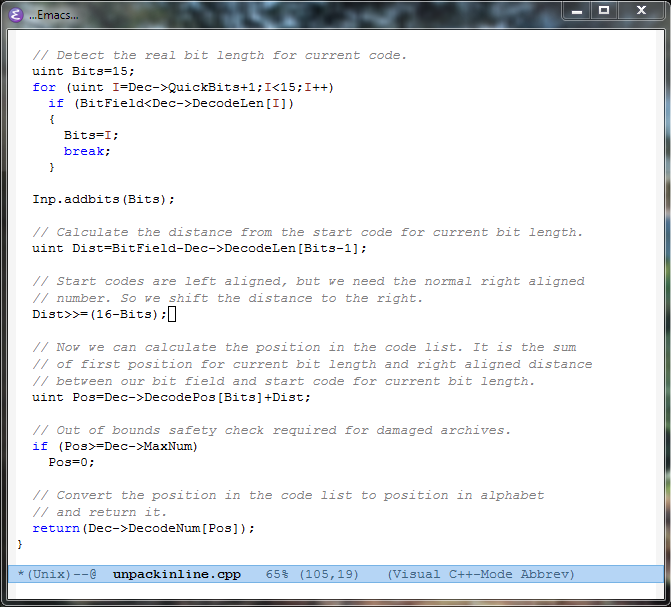

Konudaki Resimler

Konudaki Resimler

Veri sıkıştırmada kullanılan ve sıkıştırma aşamasını gerçekleştiren (bit veya byte akışlarını sağlayan) algoritmalar zaten kayıpsızdır. Ör : Huffman, AC, PPMD, BWT...

Veri sıkıştırmada kullanılan ve sıkıştırma aşamasını gerçekleştiren (bit veya byte akışlarını sağlayan) algoritmalar zaten kayıpsızdır. Ör : Huffman, AC, PPMD, BWT...