|

|

_____________________________

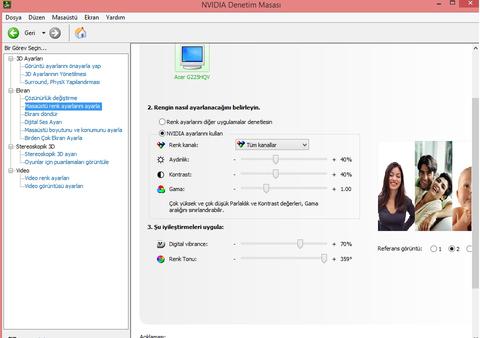

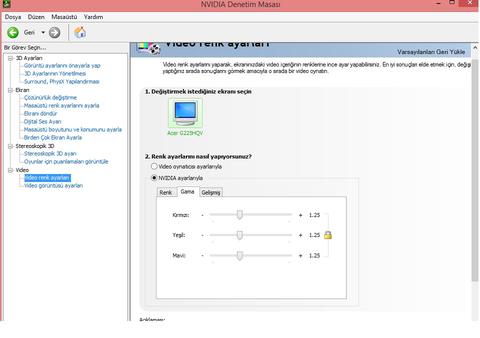

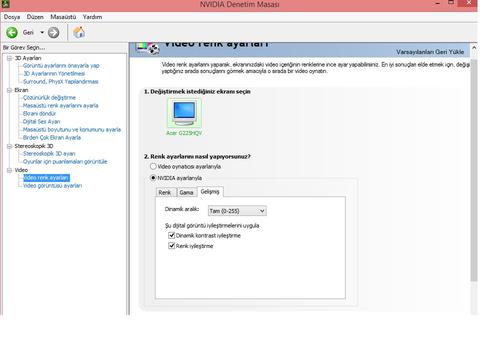

CORE i9 10900K | MSI Z490-A PRO | GIGABYTE RTX 4080 SUPER | CRUCIAL BALLISTIX 2x16GB 4300MHz CL17 | SABRENT NVMe 1TB NVIDIA RENK, PARLAKLIK, RGB | KIBRIS INTERNET ANA KONU | MIKROTIK ROUTERBOARD | AUDIOPHILE REHBER ve DRIVER | CRYSIS 3 PC MULTIPLAYER | EN AKICI VSYNC KOMBINASYON | PASCAL-KEPLER BIOS REHBER | LGA771 XEON CPU VE LGA775 | C# IMDB SEARCH | GTX670 ACCELERO HYBRID |

Yeni Kayıt

Yeni Kayıt

Konudaki Resimler

Konudaki Resimler

önceki

önceki

kullanıcısına yanıt

kullanıcısına yanıt

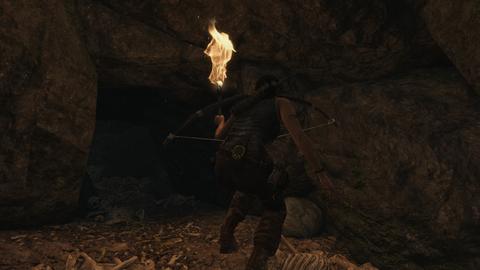

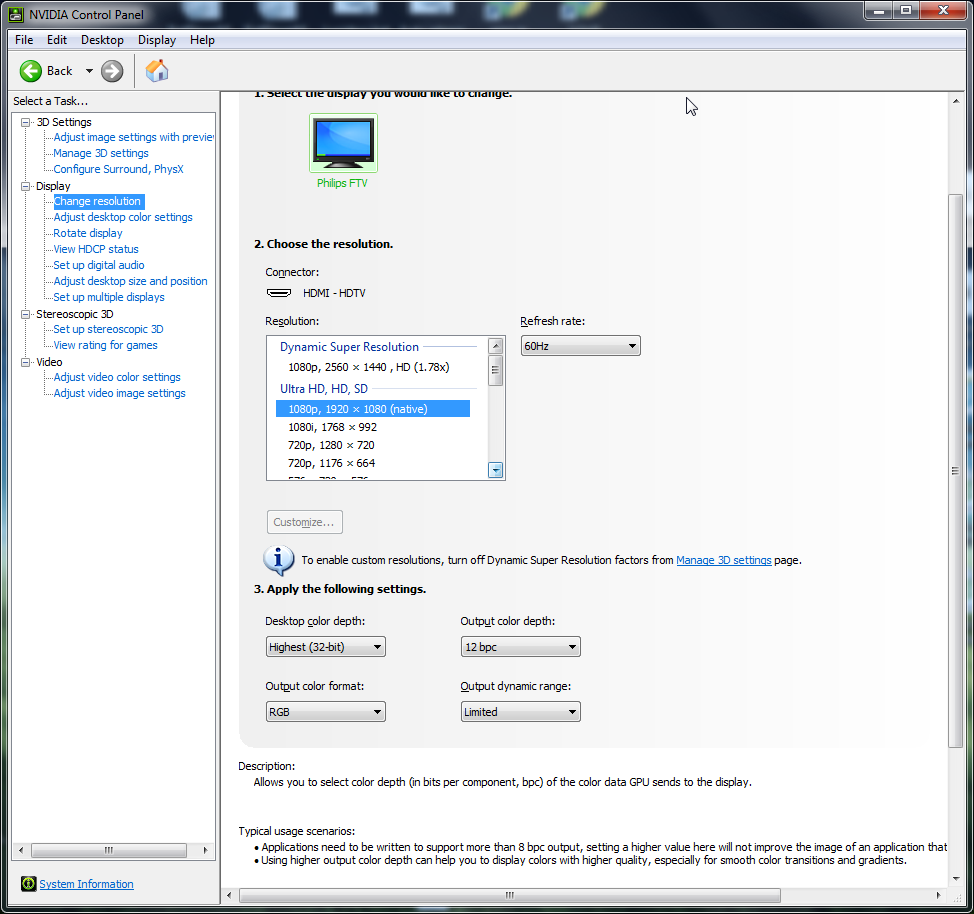

Eğer böyle bir aygıta sahipseniz, NVIDIA kart varsa denemek isteyebilrisiniz.

Eğer böyle bir aygıta sahipseniz, NVIDIA kart varsa denemek isteyebilrisiniz.

kullanıcısına yanıt

kullanıcısına yanıt

kullanıcısına yanıt

kullanıcısına yanıt

kullanıcısına yanıt

kullanıcısına yanıt