|

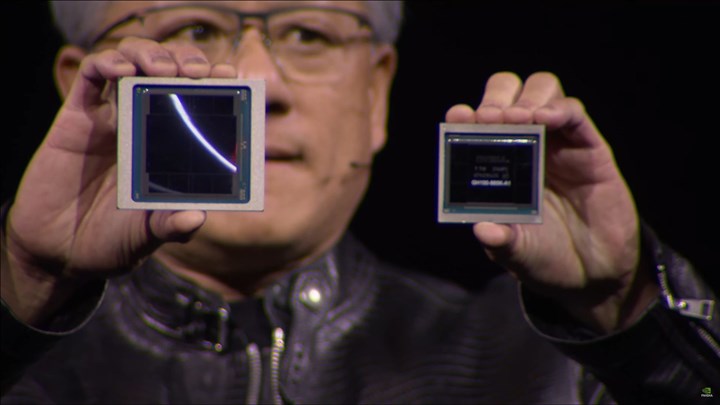

Nvidia’nın yeni nesil Blackwell çiplerinin tanesi 70 bin dolar olabilir

-

-

Olsun Nvidia. 80.000 olsun.

-

200 kilo altın istesinler. Umurumda değil. GT5010 çıkaracaklar mı o önemli. O paraya zaten baya kuvvetli FPGA alınarak çok hızlı hesaplama yapılabilir.

< Bu mesaj bu kişi tarafından değiştirildi Tugrul_512bit -- 15 Mayıs 2024; 19:11:47 > -

Madem öyle, o zaman o paraya neden baya kuvvetli FPGA alıp da çok hızlı hesaplama yapmıyorlar da gidip Blackwell için yıllık sıraya giriyorlar?

Diye sorarım şimdi ben de.

-

Büyük projelerde ar-ge yapan şirketler daha az sayıda server kullanmak için server başına daha çok GPU gücü kullanıyorlar. Bunun için de en güçlü GPU'yu kullanmak avantajlı oluyor. GPU'yu programlamak, FPGA programlamaktan çok daha kolay. Kolay olunca ar-ge süresi azalıyor. Bu çok önemli. Tabi para sınırsızsa. Bende para sınırlı. Tek çipe 70bin dolar (2.1 milyon, ev parası) vereceksem, buna değecek bir hesaplama gücü sunmalı. Yapılan işe göre bunu sağlayamayabilir. Atıyorum, bitcoin kazacak kişi GPU kullanmaz, FPGA (hatta bunun sabitlenmiş hali olan özel ASIC çipini) alır. Ayrıca FPGA içerisinde çalışan algoritmalar tamamen kullanıcının yazdığı satırlardan ibaret. Açık kaynak kodlu ve güvenilir. Ama Nvidia, bize sormadan bilgileri alıp bakabiliyor.

Ucuz et için de sıraya giriliyor hocam. Ucuz et mi daha sağlıklı yoksa kaliteli et mi?

Ucuz ekmek için de sıraya giriliyor. Burada iyi olan ekmek değil, fiyatı.

Nvidia'nın paha GPU sırasına girmelerinin sebebi, CUDA programlama araçlarının çok gelişmiş olması ve programlama süresini azaltması, kolaylaştırması. Aynı şey FPGA sistemine de yavaş yavaş geliyor, şu anda OpenCL destekleyen FPGA'lar var ama CUDA kadar gelişmemiş.

Yapılacak iş belliyse, FPGA/özel ASIC tasarımları, herhangi bir GPU'ya göre çok daha verimli çalışırlar.

< Bu mesaj bu kişi tarafından değiştirildi Tugrul_512bit -- 16 Mayıs 2024; 9:57:55 >

-

Şu iki cümle birbiri ile çelişiyor:

CÜMLE 1:

Alıntı

metni:Nvidia'nın paha GPU sırasına girmelerinin sebebi, CUDA programlama araçlarının çok gelişmiş olması ve programlama süresini azaltması, kolaylaştırması. Aynı şey FPGA sistemine de yavaş yavaş geliyor, şu anda OpenCL destekleyen FPGA'lar var ama CUDA kadar gelişmemiş. CÜMLE 2:

Alıntı

metni:Yapılacak iş belliyse, FPGA/özel ASIC tasarımları, herhangi bir GPU'ya göre çok daha verimli çalışırlar. Yapılacak iş belli, yapay zeka eğitimi. Madem FPGA CUDA'nın yeteneklerine sahip değil, nasıl verimli çalışıyor? Tükettiği enerji olarak mı kastettin hocam? O zaman farklı tabii, tekrar bakmak lazım. Ama işlem gücü ise doğru değil.

Bu trilyon dolarlık şirketler Nvidia'nın çipi için sıraya girmişler. Onlar da sonuçta FPGA falan biliyorlardır. Neden o FPGA yoluna girmiyorlar, çünkü maliyeti daha fazla, niye? Çünkü şimdiki durumda Nvidia'nın çipine parayı basıp geçiyorlar. FPGA yoluna girseler, tasarım yapacaklar, ona göre kod yazacaklar, onu ürettirecekler/dökecekler, SDK yazacaklar, vs vs vs. Çok inanılmaz uzun iş.

Dip noktada YİNE DE Nvidia'nın çözümünden daha iyi olur mu, pek sanmam açıkçası. Çünkü FPGA, TEK BİR KİLİT İŞ için tasarlanır. Ama "yapay zeka eğitimi" diyince altında çok fazla alt rutin var.

< Bu mesaj bu kişi tarafından değiştirildi V4LKyR -- 16 Mayıs 2024; 11:3:3 >

-

"Yapılacak iş belli, yapay zeka eğitimi. Madem FPGA CUDA'nın yeteneklerine sahip değil, nasıl verimli çalışıyor? "

Sadece o işi yapacak şekilde yeniden programlanarak. CUDA is sabit donanıma sahip. Yapay zeka algoritması değişirse, CUDA donanımı değişmeyeceği için ya destekleyemez ya da verimsiz kullanılır. Yenisini almak gerekir.

Ayrıca fazla alt rutin olan algoritmalar için de özel çipler tasarlanıyor. Bunlardan biri cerebras. Çipin üzerinde 18GB cache var.

Nvidia GPU satın alan kişi, sadece yapay zeka çalıştıracağı zaman, raytracing donanımına boşuna para ödemiş oluyor. FPGA ise üzerindeki elemanların %100'e yakın kısmını istenilen işe yönlendirebiliyor. Nvidia GPU, üzerinde DX12, OpenGL, ... bir ton destek sunan donanıma sahip. Sadece 1+1=2 hesaplanacağı zaman bu donanımın %90'ı boşa gidiyor. FPGA ise üzerindeki mantık elemanlarının tamamını 1+1=2 hesabı yapan devrelere dönüştürebiliyor.

< Bu mesaj bu kişi tarafından değiştirildi Tugrul_512bit -- 16 Mayıs 2024; 11:20:7 >

Bu mesaj IP'si ile atılan mesajları ara Bu kullanıcının son IP'si ile atılan mesajları ara Bu mesaj IP'si ile kullanıcı ara Bu kullanıcının son IP'si ile kullanıcı ara

KAPAT X

Yeni Kayıt

Yeni Kayıt

Konudaki Resimler

Konudaki Resimler

kullanıcısına yanıt

kullanıcısına yanıt

Hızlı

Hızlı